百度spider无法正常抓取页面,会影响到网站排名,做SEO优化就需要百度正常的收录页面,抓取异常则会停止收录,对网站也影响很大,总结一下抓取异常的原因有以下几个:

1)网站异常

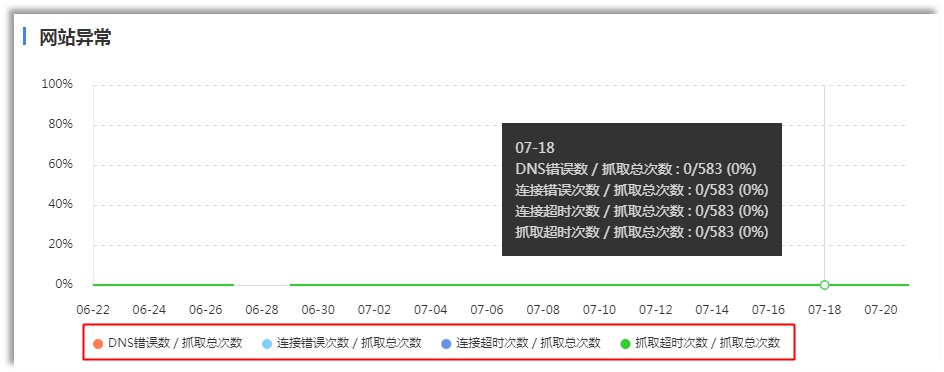

网站异常包括DNS异常、连接超时、抓取超时和链接错误四种情况。

DNS异常

当Baiduspider无法解析网站的IP时,会出现DNS异常。可能是网站IP地址错误,或者域名服务商把Baiduspider封禁。请开发者们先自查网站IP地址是否正确且可解析,如果不正确或无法解析,请与域名注册商联系,更新您的IP地址。

连接超时

抓取请求连接超时,可能是因为服务器过载或者网络不稳定。

抓取超时

抓取请求连接建立后,下载页面速度过慢,导致超时,还可能是因为服务器过载,带宽不足。

连接错误

无法连接或者连接建立后对方服务器拒绝。

2)链接异常

链接异常包括服务器错误、访问被拒绝、找不到页面和其他错误四种情况。

服务器错误:响应代码——5XX

访问被拒绝:响应代码——403

找不到页面:响应代码——404 (百度会自动进行死链屏蔽)

其他错误:响应代码——4XX(不包括403和404)